Laboratorul 07 - Advanced CUDA

Spatiu unificat memorie

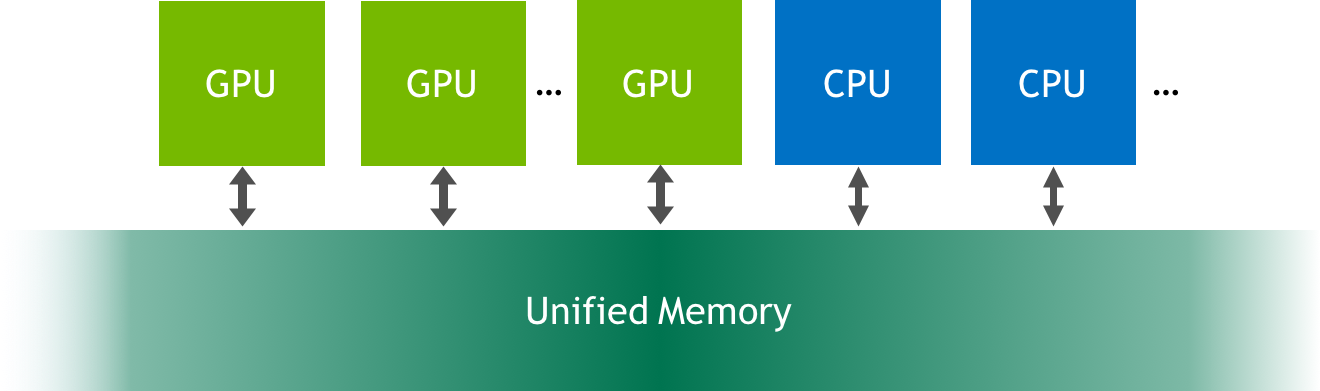

De la CUDA 6.0, NVIDIA a schimbat semnificativ modelul de programare prin facilitarea comunicarii unitatii CPU (host) cu unitatea GPU (device), in mod transparent prin acelasi set de adrese de memorie virtuale. Astfel exista posibilitatea ca prin acelasi pointer de memorie sa se scrie date atat de catre CPU cat si de catre GPU. Evident transferurile de memorie au loc intre spatii diferite de adresare (ex RAM vs VRAM), dar acest lucru se intampla transparent la nivel de aplicatie CUDA / pentru programator.

Mai jos avem un exemplu de folosire a memoriei unificate. Singura diferenta fata de alocarea pe CPU/HOST este ca memoria trebuie alocata cu cudaMallocManaged si dealocata cu cudaFree.

#include <iostream> #include <math.h> // CUDA kernel to add elements of two arrays __global__ void add(int n, float *x, float *y) { int index = blockIdx.x * blockDim.x + threadIdx.x; int stride = blockDim.x * gridDim.x; for (int i = index; i < n; i += stride) y[i] = x[i] + y[i]; } int main(void) { int N = 1<<20; float *x, *y; // Allocate Unified Memory -- accessible from CPU or GPU cudaMallocManaged(&x, N*sizeof(float)); cudaMallocManaged(&y, N*sizeof(float)); // initialize x and y arrays on the host for (int i = 0; i < N; i++) { x[i] = 1.0f; y[i] = 2.0f; } // Launch kernel on 1M elements on the GPU int blockSize = 256; int numBlocks = (N + blockSize - 1) / blockSize; add<<<numBlocks, blockSize>>>(N, x, y); // Wait for GPU to finish before accessing on host cudaDeviceSynchronize(); // Check for errors (all values should be 3.0f) float maxError = 0.0f; for (int i = 0; i < N; i++) maxError = fmax(maxError, fabs(y[i]-3.0f)); std::cout << "Max error: " << maxError << std::endl; // Free memory cudaFree(x); cudaFree(y); return 0; }

Operatii atomice CUDA

CUDA ofera acces la multiple operatii atomice tip citire-modificare-scriere. Acestea presupun serializarea accesului in contextul mai multor thread-uri. Functiile sunt limitate la anumite tipuri de date:

- int

- unsigned int

- unsigned long long int

- float

- double

Exemple de functii atomice:

In codul de mai jos se lanseaza un kernel concurrentRW in configuratie numBlocks=8 fiecare cu cate 10 thread-uri.

#include <iostream> #define NUM_ELEM 8 #define NUM_THREADS 10 using namespace std; __global__ void concurrentRW(int *data) { ... } int main(int argc, char *argv[]) { int* data = NULL; bool errorsDetected = false; cudaMallocManaged(&data, NUM_ELEM * sizeof(unsigned long long int)); if (data == 0) { cout << "[HOST] Couldn't allocate memory\n"; return 1; } // init all elements to 0 cudaMemset(data, 0, NUM_ELEM * sizeof(unsigned long long int)); // launch kernel writes concurrentRW<<<NUM_ELEM, NUM_THREADS>>>(data); cudaDeviceSynchronize(); if (cudaSuccess != cudaGetLastError()) { return 1; } for(int i = 0; i < NUM_ELEM; i++) { cout << i << ". " << data[i] << endl; if(data[i] != (NUM_THREADS * (NUM_THREADS - 1) / 2)) { errorsDetected = true; } } if(errorsDetected) { cout << "Errors detected" << endl; } else { cout << "OK" << endl; } return 0; }

Functia concurrentRW citeste valoarea de la adresa data[blockIdx.x], o incrementeaza cu threadIdx.x si apoi o scrie. In acest caz avem 10 thread-uri care fac operatii citire/scriere la aceeasi adresa, deci un comportament nedefinit.

__global__ void concurrentRW(int *data) { // NUM_THREADS try to read and write at same location data[blockIdx.x] = data[blockIdx.x] + threadIdx.x; }

Exemplu rezultat:

0. 9 1. 9 2. 9 3. 9 4. 9 5. 9 6. 9 7. 9 Errors detected

Corect ar fi folosirea functiei atomicAdd pentru a serializa accesul.

__global__ void concurrentRW(int *data) { // NUM_THREADS try to read and write at same location atomicAdd(&data[blockIdx.x], threadIdx.x); }

Rezultatul rularii este:

0. 45 1. 45 2. 45 3. 45 4. 45 5. 45 6. 45 7. 45 OK

Operatii atomice system wide

Unitatile GPU ce au Compute capability 6.x permit largirea scopului operatiilor atomice. De exemplu atomicAdd_system garanteaza ca operatia este atomica cand atat thread-urile de pe unitatea GPU cat si cele de pe unitatea CPU incearca sa acceseze datele. Mai jos avem un exemplu de folosire al functiei atomicAdd_system.

__global__ void mykernel(int *addr) { atomicAdd_system(addr, 10); // only available on devices with compute capability 6.x } void foo() { int *addr; cudaMallocManaged(&addr, 4); *addr = 0; mykernel<<<...>>>(addr); __sync_fetch_and_add(addr, 10); // CPU atomic operation }

Operatii asincrone CUDA

In CUDA, urmatoarele operatii sunt definite ca fiind independente si pot fi executate concurent:

- Calcule pe unitatea host

- Calcule pe unitatea device

- Transfer memorie host → device

- Transfer memorie device → host

- Transfer memorie device → device

Nivelul de concurenta o sa depinda si de capabilitatea unitatilor GPU (compute capability). In continuare vom explora mai multe scenarii de executie concurenta a operatiilor descrise.

Executie asincrona Host si Device

Folosind apeluri asincrone, operatiile de executie catre device sunt puse in coada avand controlul intors catre host instant. Astfel unitatea host poate continua executia fara sa fie blocata in asteptarea altor task-uri. Urmatoarele operatii sunt asincrone relativ la host:

- Lansari de kernel

- Copieri in cadrul spatiului de memorie al unui device

- Copiere memorie host → device, avand < 64 KB

- Copiere memorie host → device, avand functii cu sufix Async

- Functii memorie set (setare / initializare de memorie la o valoare)

Pentru a face debug unor scenarii de executie asincrona se poate dezactiva complet executia asincrona setand variabila de mediu CUDA_LAUNCH_BLOCKING la 1. Executia de kernels este sincrona cand se ruleaza cu un profiler (Nsight, Visual Profiler).

Fluxuri nonimplicite

Pentru a folosi cudaMemcpyAsync, este necesar lucrul cu fluxuri nonimplicite (non-default streams), care, in C/C++ pot fi declarate, create si distruse in partea de cod de pe host (CPU) in urmatorul fel:

cudaStream_t stream1; cudaError_t result; result = cudaStreamCreate(&stream1); result = cudaStreamDestroy(stream1);

Odata creat un astfel de flux, el poate fi utilizat in procesul de copiere a memoriei host → device astfel:

// num_bytes = N * sizeof (type_a); result = cudaMemcpyAsync(d_a, a, num_bytes, cudaMemcpyHostToDevice, stream1);

Pentru a emite un kernel către un flux nonimplicit, specificăm identificatorul fluxului ca al patrulea parametru de configurare a execuției. Se observă și un al treilea parametru de configurare a execuției, care este folosit pentru a aloca memorie partajată (shared memory) device-ului (GPU-ului), utilizându-se 0 dacă nu se dorește acest aspect.

increment<<<1,N,0,stream1>>>(d_a);

Executie asincrona programe kernel

Arhitecturile cu compute capability 2.x sau mai nou, pot executa in paralel instante de kernel diferite. Aceste unitati de executie o sa aibe proprietate concurrentKernels setata la 1 (se face query la device properties inainte). Numarul maxim de lansari asincrone de kernele diferite este dependent de arhitectura (se verifica in functie de compute capability). Singura restrictie este ca programele kernel sa fie in acelasi context.

Executie si transfer date asincron

Anumite device-uri pot executa un transfer asincron memorie alaturi de o executie de kernel. Acest lucru este dependent de compute capability si se poate verifica in device property asyncEngineCount.

De asemenea, se pot face transferuri de memorie intra-device simultan cu executia de kernel cand atat device property concurrentKernels, cat si asyncEngineCount sunt 1.

Dynamic Paralellism

Paralelismul dinamic consta in posibilitatea de a lansa programe kernel din thread-urile ce ruleaza pe device/GPU. In alte cuvinte, unitatea GPU poate sa isi atribuie noi task-uri/thread-uri fara interventia unitatii host/CPU. Aceasta manifestare este utila in problemele unde maparea threaduri↔date nu este simpla/triviala. De exemplu, in situatia unde unele thread-uri ar avea prea putin de lucru, iar altele prea mult (imaginea de mai jos, simulare fluide) - o situatia debalansata computational.

Cerintele pentru paralelism dinamic sunt CUDA 5.0 ca Toolkit si respectiv Compute Capability 3.5. O lista cu GPU-uri NVIDIA si Compute Capability se regaseste aici.

Exercitii

Urmăriți instrucțiunile de pe GitLab.

exit

Alternativ, daca ati uitat sesiuni deschise, puteti verifica acest lucru de pe fep8.grid.pub.ro, utilizand comanda squeue. In cazul in care identificati astfel de sesiuni “agatate”, le puteti sterge (si va rugam sa faceti asta), utilizand comanda scancel ID unde ID-ul il identificati din comanda anterioara squeue. Puteți folosi mai precis squeue -u username (username de pe fep8.grid.pub.ro) pentru a vedea doar sesiunile care vă interesează. (Sau squeue –me).

Daca nu veti face aceasta delogare, veti putea ajunge in situatia in care sa nu va mai puteti loga pe nodurile din cluster.

Resurse

- Responsabili laborator: Matei Barbu, Alexandru Bala

Referinte

- Bibliografie

- Documentatie CUDA:

- Acceleratoare xl (NVidia P100)

- Advanced CUDA